Мир искусственного интеллекта все еще выясняет, как бороться с удивительным проявлением изобретательности. DALL-E 2 может рисовать/раскрашивать/воображать что угодно… но OpenAI не единственный, кто работает над чем-то подобным. Google Research поспешила объявить об аналогичной модели, над которой они работали, но которая, как утверждается, даже лучше.

Изображение (Понятно?) — это генератор преобразования текста в изображение, построенный на языковых моделях великих конвертеров… Хорошо, давайте замедлимся и расшифруем это очень быстро.

Формы преобразования текста в изображение принимают вводимый текст, например «собака на велосипеде», и создают соответствующее изображение, что делалось годами, но в последнее время наблюдается огромный скачок в качестве и доступности.

Частью этого является использование методов распространения, которые в основном начинают с чистого изображения шума и постепенно улучшают его, пока модель не решит, что не может сделать его более похожим на собаку на велосипеде, чем это есть на самом деле. Это было улучшением по сравнению с нисходящими генераторами, которые могут до смешного ошибаться при первом же предположении, и другими генераторами, которые легко ввести в заблуждение.

Другая часть заключается в улучшении понимания языка с помощью большие языковые модели Используя подход преобразования, я не буду (и не могу) вдаваться в технические аспекты, но они и некоторые другие недавние достижения привели к убедительным языковым парадигмам, таким как GPT-3 и другие.

Кредиты изображений: поиск Гугл

Imagen начинает с создания небольшого изображения (64 x 64 пикселя), а затем передает его «ультра-разрешение» до 1024 x 1024. Это не похоже на обычное обновление, хотя сверхвысокое разрешение ИИ создает новые детали, которые сливаются с изображением. изображение меньшего размера, взяв за основу оригинал.

Предположим, например, что у вас есть собака на велосипеде, и ширина глаза собаки на первом изображении составляет 3 пикселя. Не так много места для самовыражения! Но на втором изображении ширина 12 пикселей. Откуда берутся необходимые для этого детали? Что ж, ИИ знает, как выглядит собачий глаз, поэтому генерирует больше деталей по мере того, как вы его рисуете. Затем это происходит снова, когда глаз снова сделан, но шириной 48px. Но ИИ никогда не приходилось вытаскивать 48 пикселей любого пикселя из собачьего глаза… скажем, из волшебного мешка. Как и многие художники, он начал с эквивалента чернового наброска, дополнил его этюдом, а затем уже фактически отправился в город на готовом полотне.

Это не беспрецедентно, и на самом деле художники, работающие с моделями ИИ, уже используют эту технологию для создания гораздо более крупных объектов, чем ИИ может обработать за один раз. Если разбить доску на несколько частей, причем очень точно для каждой из них в отдельности, то получится нечто гораздо большее и более подробное; Вы можете делать это неоднократно. Интересный пример От знакомого мне художника:

Исследователи Google утверждают, что разработки Imagen многочисленны. Они говорят, что существующие текстовые шаблоны могут использоваться для части разметки текста, и что их качество важнее, чем просто повышение визуальной точности. Интуитивно это имеет смысл, потому что подробная картинка херни определенно хуже, чем чуть менее подробная картинка именно того, что вы просили.

Например, в бумага Чтобы описать Imagen, они сравнили свои результаты и DALL-E 2 с созданием «панды, готовящей латте-арт». На всех картинках последнего это латте-арт панды; На большинстве изображений Imagen панды создают искусство. (Ни один из них не смог заставить лошадь ездить на астронавте, что показывает обратное во всех попытках. Работа еще не завершена.)

Кредиты изображений: поиск Гугл

В тестах Google Imagen превзошел человеческие тесты по точности и достоверности. Это, очевидно, довольно субъективно, но даже если сравнивать с воспринимаемым качеством DALL-E 2, которое до сегодняшнего дня было огромным скачком выше всего остального, это впечатляет. Я просто добавлю, что, хотя они очень хороши, ни одно из этих изображений (из любого генератора) не выдержит ничего, кроме быстрой проверки, прежде чем люди заметят, что они были созданы, или у них возникнут серьезные сомнения.

Несмотря на это, OpenAI на один-два шага опережает Google по двум параметрам. DALL-E 2 — это больше, чем просто исследовательская работа, это закрытая бета-версия, которую люди используют так же, как они использовали ее предшественников и GPT-2 и 3. По иронии судьбы, компания со словом «открытый» в своем названии сосредоточилась на производстве свой текстовый поиск изображений, в то время как сказочно прибыльный интернет-гигант еще не пробовал.

Это более очевидно, чем выбор, сделанный исследователями DALL-E 2, для предварительного форматирования набора обучающих данных и удаления любого контента, который может нарушать их собственные правила. Модель не сможет сделать вещь NSFW, если попытается. Однако команда Google использовала несколько больших наборов данных, которые, как известно, содержат неприемлемые материалы. В проницательном разделе Imagen, описывающем «Ограничения и влияние на общество», исследователи написали:

Последующие приложения моделей преобразования текста в изображение разнообразны и могут сложным образом влиять на общество. Потенциальные риски неправильного использования вызывают опасения по поводу ответственного открытого исходного кода и демоверсий. На данный момент мы решили не выпускать иконку или публичную демоверсию.

Требования к данным для моделей преобразования текста в изображение побудили исследователей в значительной степени полагаться на большие, часто ненасыщенные наборы данных, полученные из Интернета. Хотя этот подход позволил в последние годы быстро продвинуть алгоритмы, наборы данных этого типа часто отражают социальные стереотипы, репрессивные точки зрения и унижающие достоинство или иным образом вредные ассоциации с маргинализованными группами идентичности. Хотя подмножество наших обучающих данных было отфильтровано для удаления шума и нежелательного контента, такого как порнографические изображения и ненормативная лексика, мы также использовали набор данных LAION-400M, который, как известно, содержит широкий спектр неприемлемого контента, включая порнографические изображения, расистские оскорбления и стереотипы. вредные соц. Imagen полагается на текстовые кодеки, обученные на ненасыщенных сетевых данных, таким образом унаследовав социальные предубеждения и ограничения больших языковых моделей. Таким образом, существует риск того, что Imagen закодировал вредные стереотипы и представления, что определяет наше решение не выпускать Imagen для публичного использования без дополнительных мер безопасности.

Хотя некоторые могут отмахнуться от этого, говоря, что Google опасается, что его ИИ может быть недостаточно политкорректным, это нетерпимая и недальновидная точка зрения. Модель ИИ так же хороша, как и данные, на которых она была обучена, и не каждая команда может потратить время и усилия, необходимые для удаления ужасных вещей, которые собирают эти парсеры, собирая несколько миллионов изображений или миллиарды изображений. наборы словесных данных.

Предположительно, такие предубеждения возникают в процессе исследования, которое раскрывает, как работают системы, и обеспечивает беспрепятственный полигон для выявления этих и других ограничений. Иначе откуда мы знаем, что ИИ не может рисовать популярные черные прически — прически, которые может нарисовать любой ребенок? Или что, когда вас просят написать рассказы о рабочей среде, ИИ всегда делает босса мужчиной? В этих случаях модель ИИ работает идеально и как задумано — она успешно изучила предубеждения, которые пронизывают обучаемые медиа. Не отличается от людей!

Но в то время как устранение системной предвзятости — это пожизненный проект для многих людей, ИИ проще, и его создатели могут удалить контент, который изначально заставлял их вести себя плохо. Возможно, когда-нибудь ИИ понадобится, чтобы писать в стиле расистского сексистского эксперта из 1950-х годов, но пока преимущества включения этих данных невелики, а риски значительны.

В любом случае, Imagen, как и другие, явно все еще находится в стадии бета-тестирования и не готов работать ни над чем, кроме как под строгим контролем человека. Поскольку Google упрощает доступ к своим возможностям, я уверен, что мы узнаем больше о том, как это работает и почему.

«Зомби-любитель-евангелист. Неизлечимый создатель. Гордый новатор в твиттере. Любитель еды. Интернетоголик. Жесткий интроверт».

More Stories

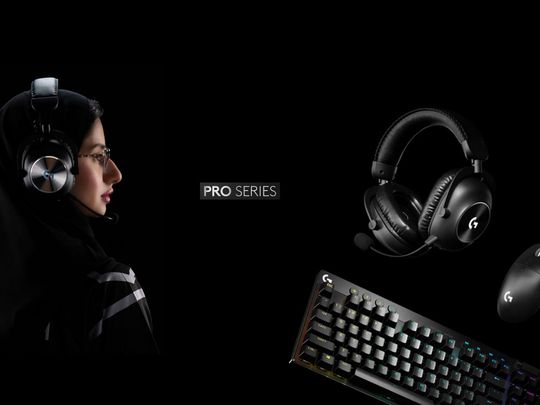

Logitech представляет новейшую игровую клавиатуру и мышь серии Pro

Пользователи Apple в Европе получают новый сторонний магазин приложений

AMD анонсирует процессоры серий Ryzen Pro 8000 и Ryzen Pro 8040: настольные компьютеры для бизнеса получают искусственный интеллект